本周Hiddenlayer完成5000万美元A轮融资标志着大语言模型安全工具正在成为企业和资本追逐的热点。

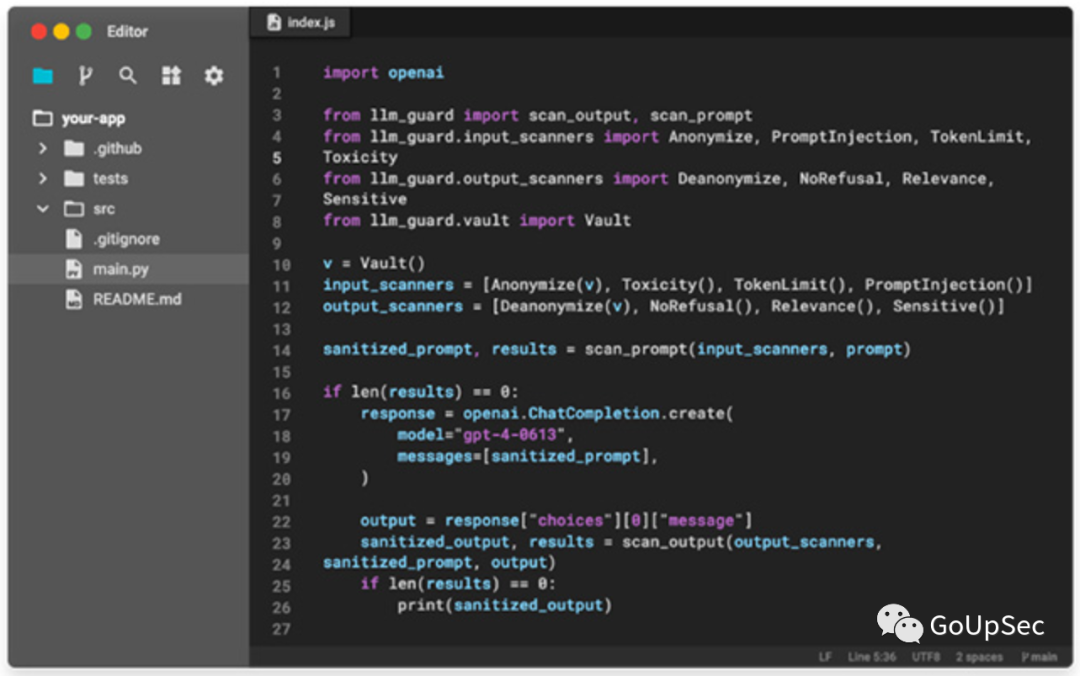

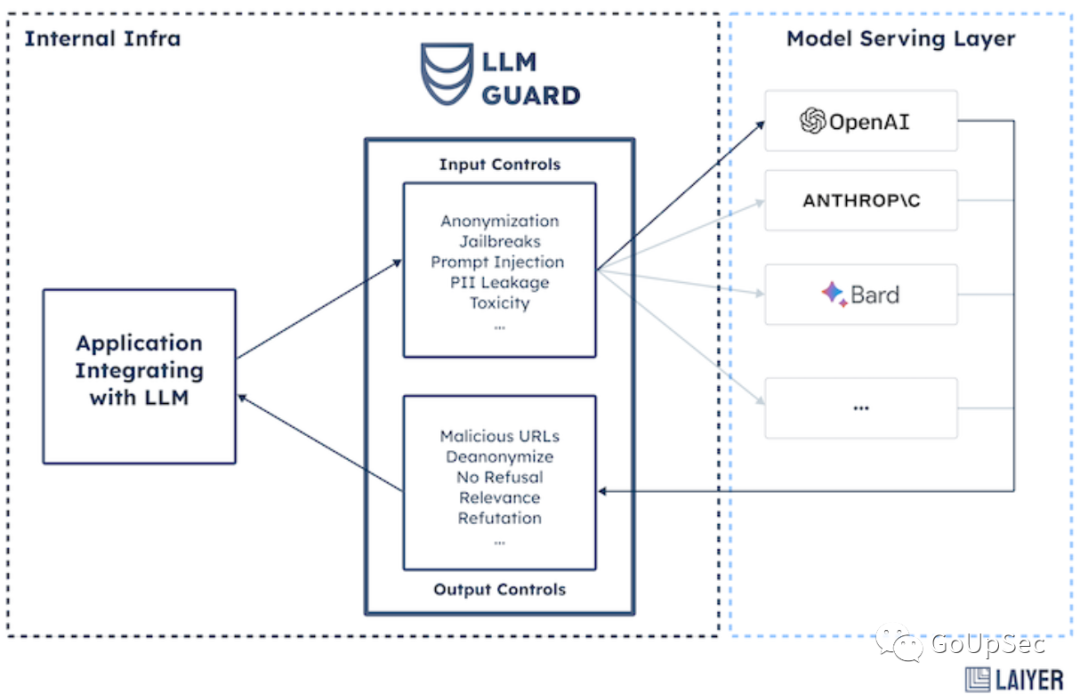

本文介绍的LLM Guard是一个保护和强化大型语言模型(LLM)安全性的开源工具包,专为在生产环境中集成和部署而设计。

LLM Guard为大语言模型的输入和输出内容提供了全面的评估和保护功能,包括清理、有害语言和数据泄漏检测以及防止提示注入和越狱攻击。

LLM Guard的开发目的很简单:尽管大语言模型可以提高员工生产力,但企业对大语言模型在生产环境的部署始终疑虑重重,因为大语言模型存在数据泄露、提示攻击、分析偏见、错误信息(AI幻觉)等重大安全风险,而且这些AI模型普遍缺乏控制和可观察性。

LLM Guard的创建者之一Oleksandr Yaremchuk告诉Help Net Security:“我们希望它成为市场上首选的开源安全工具包,通过提供开箱即用的所有必要工具来简化公司安全采用LLM的过程”。

“LLM Guard经历了一些令人兴奋的更新,我们很快就会推出这些更新,包括为社区提供更好的文档、对GPU推理的支持,以及我们最近在HuggingFace上部署的LLM Guard Playground。在接下来的一个月里,我们将发布我们的安全API(LLM Guard的云版本),重点是确保低延迟的性能并加强输出评估/AI幻觉识别。”Yaremchuk补充道。

LLM Guard目前已经在GitHub上发布(https://github.com/laiyer-ai/llm-guard),可用于防护和强化任何应用于生产环境的大语言模型,包括ChatGPT、Claude、Bard等基础模型。